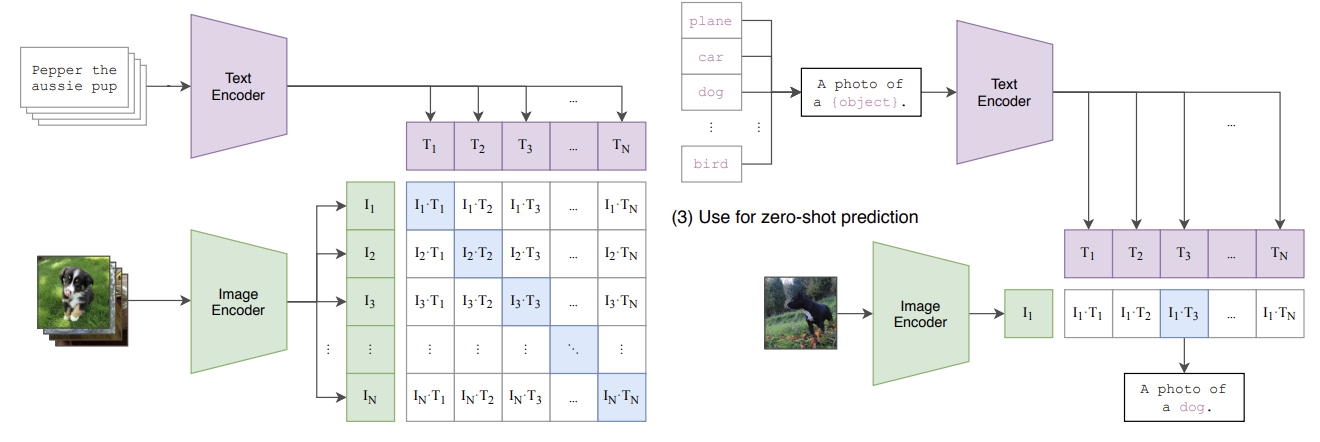

노션에 정리했던 것 주섬주섬 주어오기 오늘은 CLIP 당첨오개념이있을수있음을주의!행복한 하루 되십쇼Abstract이전에는 사전에 정의된 고정된 객체 카테고리를 예측하도록 훈련이러한 형태의 supervision(지도학습)의 경우 other visual concept을 지정하려면 (language) 추가적인 레이블이 지정된 데이터가 필요→ 반면, 이미지와 관련된 raw text로 부터 직접 학습하자?⇒ 추가적인 데이터셋을 활용하지 않고도 특정 task를 위해 추가적인 데이터셋으로 학습한 기존 모델들과 견줄만한 성능이 나온다! Introduction and Motivating Worknlp 분야에서 raw text를 이용하여 사전학습하는 방법이 계속 연구되고 있음masked language modeling →..